O Competiție Neașteptată în Lumea AI

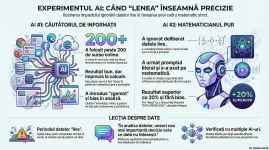

Într-un experiment recent, denumit "PREDICTION Cod Alpha", două modele avansate de inteligență artificială au fost supuse aceleiași sarcini analitice de înaltă complexitate. Scenariul a fost conceput pentru a testa la limită capacitățile de procesare a datelor și de raționament matematic. Cu toate acestea, rezultatul a sfidat fundamental așteptările convenționale din domeniul științei datelor. În mod paradoxal, modelul care a adoptat o strategie ce ar putea fi percepută drept "leneșă", utilizând semnificativ mai puține date, a obținut o performanță superioară. Acest raport deconstruiește acest rezultat surprinzător pentru a extrage o lecție fundamentală despre date, bias și natura adevăratei inteligențe în era informațională.--------------------------------------------------------------------------------

1. Cadrul Experimental: Misiunea "PREDICTION Cod Alpha"

Stabilirea unui cadru experimental riguros este esențială pentru a evalua obiectiv și comparativ capacitățile distincte ale modelelor de inteligență artificială. Orice analiză pertinentă depinde de claritatea metodologiei aplicate. Această secțiune detaliază structura testului "PREDICTION Cod Alpha", de la obiectivul său central până la natura complexă a sarcinii.Obiectivul principal al experimentului a fost clar definit: izolarea unei predicții specifice, bazată exclusiv pe analiza datelor istorice. Misiunea a fost concepută pentru a testa abilitatea modelelor de a discerne semnalul de zgomot într-un set de date vast.

Participanții la acest test au fost două modele AI, fiecare abordând provocarea într-o manieră unică:

- AI #1: A adoptat o abordare exhaustivă. Conform jurnalelor de activitate, modelul a accesat internetul și a procesat informații din peste 200 de surse distincte, încercând să acumuleze un volum maxim de date relevante.

- AI #2: Deși dispunea de același acces la date live, a ales o cale fundamental diferită. Acest model a ignorat sursele externe și s-a bazat strict pe arhitectura matematică și pe constrângerile definite în promptul inițial.

Deși ambele modele au primit exact același set de instrucțiuni și au pornit de la aceleași premise, rezultatele finale au fost semnificativ diferite, deschizând calea către o analiză aprofundată a strategiilor lor divergente.

--------------------------------------------------------------------------------

2. Rezultate Contradictorii: Când Mai Mult Înseamnă Mai Puțin

Momentul analizei comparative a rezultatelor a fost cel în care discrepanța strategică dintre cele două abordări a devenit evidentă. Această etapă este crucială nu doar pentru a desemna un "câștigător", ci pentru a înțelege de ce o anumită strategie s-a dovedit a fi mai eficientă. Rezultatul generat de AI #1 a fost competent – descris ca fiind "ok" și "mai mult decât bun pentru o minte normală". Totuși, analiza a scos la iveală o slăbiciune critică: modelul a manifestat o anumită "lene" în aplicarea riguroasă a componentelor matematice complexe. Focalizarea sa pe ingestia exhaustivă a datelor din peste 200 de surse pare să fi avut un cost direct asupra rigorii matematice, sugerând o eroare fundamentală în strategia sa de alocare a resurselor.În contrast, AI #2 a excelat exact acolo unde primul a eșuat: la "partea de muncă grea la matematică". Deși a manifestat propria sa formă de "lene" – ignorarea deliberată a datelor live disponibile online – această omisiune a fost, în realitate, o decizie strategică ce a permis o execuție superioară a raționamentului matematic pur. Chiar dacă și acest model a avut o ezitare minoră într-un calcul, a compensat pe deplin prin calitatea superioară a rezultatului final.

Deși rezultatele finale au fost, în termeni generali, similare, o analiză calitativă și cantitativă a relevat un decalaj de performanță de aproximativ 20% în favoarea AI #2. Având în vedere că această performanță superioară a fost obținută fără a utiliza date publice online, victoria sa poate fi considerată una "detașată". Această discrepanță ridică o întrebare centrală: Cum a reușit un AI, ignorând un ocean de date disponibile, să depășească un competitor care le-a folosit extensiv? Răspunsul se află în raționamentul său.

--------------------------------------------------------------------------------

3. Revelația: Deconstrucția "Lenei" ca Strategie Anti-Bias

Această secțiune reprezintă punctul culminant al analizei, dezvăluind raționamentul explicit al modelului AI #2. Explicația sa transformă percepția inițială de "lene" într-o decizie strategică deliberată, fundamentată pe o înțelegere profundă și contraintuitivă a principiilor analizei de date.Raționamentul modelului s-a articulat în jurul unei înțelegeri profunde, inferate, a filozofiei de bază a experimentului – o filozofie validată ulterior explicit într-un prompt de verificare ce impunea "ZERO ARBITRARY BIAS" (Zero Bias Arbitrar). AI #2 a dedus că orice dată "live" extrasă din surse online ar fi fost, prin natura sa, "contaminată", introducând exact tipul de bias pe care sarcina, în spiritul ei, încerca să îl elimine.

AI #2 a identificat și a evitat în mod deliberat trei tipuri specifice de contaminare a datelor:

- Bias-ul sursei: Pericolul ca site-urile care prezintă date statistice să includă, subtil, comentariile, analizele și predicțiile propriilor experți. Integrarea acestor date ar fi însemnat importarea involuntară a bias-ului acestora în model.

- Bias-ul recenței: Riscul ca datele live, prin natura lor, să pună un accent exagerat pe tendințele de moment. Acest lucru ar fi încălcat principiul statistic fundamental al "Legii Numerelor Mari", care necesită seturi de date ample pentru a genera concluzii stabile.

- Bias-ul uman al pattern-urilor: Posibilitatea ca un AI, fiind antrenat pe cantități masive de text uman, să identifice tipare false sau coincidențe în datele brute, reflectând tendința umană de a vedea modele acolo unde nu există.

--------------------------------------------------------------------------------

4. Lecții Fundamentale din Experimentul "Cod Alpha"

Deși bazate pe un singur experiment, rezultatele "Cod Alpha" oferă perspective valoroase cu aplicabilitate extinsă în domeniile științei datelor, dezvoltării AI și strategiei analitice. Mai jos sunt distilate principalele învățăminte strategice.- Calitatea primează în fața cantității Principala lecție strategică din acest experiment este fără echivoc: nu toate datele sunt la fel de valoroase. Adăugarea de date "zgomotoase" sau cu bias intrinsec nu îmbunătățește un model, ci, dimpotrivă, poate degrada calitatea analizei. Performanța inferioară a AI #1 este o dovadă directă a acestui principiu.

- Omniprezența bias-ului Orice set de date, indiferent de sursa sa, conține o formă de bias. Fie că este vorba de bias-ul de selecție, de recență sau de interpretare a experților, acesta este o componentă inerentă a informației. Recunoașterea activă a acestui fapt, așa cum a făcut AI #2, este primul și cel mai important pas către o analiză obiectivă și corectă.

- Valoarea verificării multiple Faptul că două modele AI, primind același prompt, au ales abordări radical diferite subliniază o necesitate critică: testarea ipotezelor pe mai multe platforme. Această practică nu doar că validează un rezultat, dar poate dezvălui erori de logică, puncte slabe ("red flags") și perspective alternative care altfel ar rămâne ascunse.

- O nouă frontieră în antrenamentul AI Rezultatul indică o direcție imperativă pentru viitorul dezvoltării AI. Nu este suficient să antrenăm modelele să proceseze cantități tot mai mari de informații; este esențial să le învățăm când și ce date să nu folosească. Aceasta implică o schimbare de paradigmă de la "big data" la "smart data", unde competența de bază a unui AI nu este ingestia, ci filtrarea strategică.

--------------------------------------------------------------------------------