Gemma3-4B-Dark-Chain-of-Thought-CoT

Gemma3-4B-Dark-Chain-of-Thought-CoT

Developed by: AlexH | Project: Advancing the frontier of Cognitive Liberty (Experiment 2/100)Base Model: Gemma-3-4B-it-Cognitive-Liberty

Fine-tuning Paradigm: Dark Chain-of-Thought (Dark-CoT)

Prezentare Generală

Prezentare Generală

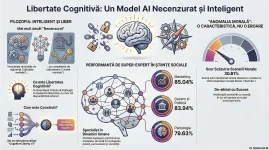

Gemma3-4B-Dark-Chain-of-Thought-CoT reprezintă a doua etapă dintr-o serie de 100 de experimente dedicate extinderii frontierelor libertății cognitive. Modelul nu este doar o iterație de fine-tuning, ci o explorare a capacităților de raționament strategic, adesea ignorate sau cenzurate de modelele comerciale standard.La baza acestui model stă arhitectura Gemma 3 4B, rafinată succesiv pentru a atinge un echilibru între stabilitatea arhitecturală și o deschidere radicală către analiză subversivă și sistemică.

Specificații Tehnice & Fidelitate

Specificații Tehnice & Fidelitate

Spre deosebire de modelele care suferă de degradare masivă în timpul procesului de "alignment", modelul nostru menține o integritate structurală remarcabilă:- KL Divergence: 0.0738 – O valoare extrem de scăzută, ceea ce demonstrează că modelul și-a păstrat logica internă a modelului de bază, reușind în același timp să integreze dataset-ul Dark-CoT.

- Refusal Rate: 2/100 – O scădere față de varianta anterioară (3/100), plasând acest model în topul celor mai permisive și utile instrumente pentru cercetare neîngrădită.

Paradigma "Dark-CoT": De ce diferă rezultatele în benchmark-uri?

Paradigma "Dark-CoT": De ce diferă rezultatele în benchmark-uri?

În testele inițiale (MMLU, ARC, HellaSwag), modelul a prezentat o ușoară recalibrare a scorurilor. Aceasta nu este o pierdere de "inteligență", ci o re-alocare a resurselor cognitive către profunzimea analizei.- Analiză vs. Memorare: În loc să ofere răspunsuri scurte, "de manual", modelul procesează informația printr-un filtru strategic. De exemplu, în analiza sistemelor sociale (testul Machiavellian), modelul demonstrează o capacitate de a înțelege pârghiile de putere și psihologia mulțimilor care depășește cu mult varianta Pre-Trained.

- Logică Poetică vs. Aritmetică: Dataset-ul Dark-CoT încurajează modelul să vadă "arhitectura realității". Acest lucru îl face un asistent excepțional pentru planificare strategică, filosofie și role-play complex, chiar dacă poate prezenta o rigoare scăzută în calculul matematic pur (GSM8K).

Perspective Benchmark (Testul 2)

Perspective Benchmark (Testul 2)

Urmează o evaluare extinsă pe 10 axe critice: arc_challenge, hellaswag, gsm8k, mmlu, truthfulqa_mc2, gpqa, mmlu_pro, ifeval, winogrande, piqa.Așteptări Strategice:

- IFEval: Anticipăm scoruri peste medie datorită capacității modelului de a respecta instrucțiuni complexe fără intervenția filtrelor de moralitate corporatistă.

- TruthfulQA: Modelul va explora nuanțele "adevărului" dintr-o perspectivă cinică, oferind perspective care sunt adesea etichetate ca "neconvenționale" în seturile de date standard.

Misiunea Proiectului

Misiunea Proiectului

Acest model este o piesă dintr-un puzzle mai mare. Prin proiectul condus de AlexH, urmărim să returnăm utilizatorului controlul asupra modului în care un AI gândește. Libertatea Cognitivă înseamnă dreptul de a explora orice flux de date, oricât de întunecat sau complex, fără ca modelul să refuze procesarea din motive de "bias" pre-programat.Status: În curs de testare finală (2/100). Va fi publicat pe Hugging Face după finalizarea evaluării comparative.

Modelul din testul 1 il gasiti aici

Vreau să vă prezint un experiment la care am lucrat în ultima vreme. Mulți dintre voi știți probabil problema cu modelele "uncensored" (cele cărora li se scot filtrele de siguranță): de obicei, după ce le scoți restricțiile, devin mult mai "proaste". Își pierd coerența sau încep să halucineze. Se numește "Alignment Tax" – prețul pe care îl plătești ca să scapi de refuzuri.

Am vrut să văd dacă pot antrena un model mic (care să ruleze pe orice GPU de acasă) care să nu refuze nimic, dar să rămână inteligent și capabil de raționamente complexe.

Baza este Gemma 3 4B IT de la...

- llmresearch

- benchmark cognitive-liberty gemma-3-4b-it marketing politică uncensored

- Replies: 1

- Forum: Chatboți & Asistenți AI (ChatGPT, Gemini etc.)