Vreau să vă prezint un experiment la care am lucrat în ultima vreme. Mulți dintre voi știți probabil problema cu modelele "uncensored" (cele cărora li se scot filtrele de siguranță): de obicei, după ce le scoți restricțiile, devin mult mai "proaste". Își pierd coerența sau încep să halucineze. Se numește "Alignment Tax" – prețul pe care îl plătești ca să scapi de refuzuri.

Am vrut să văd dacă pot antrena un model mic (care să ruleze pe orice GPU de acasă) care să nu refuze nimic, dar să rămână inteligent și capabil de raționamente complexe.

Baza este Gemma 3 4B IT de la Google, peste care am aplicat un fine-tune agresiv cu un dataset custom, axat pe filozofie, teoria jocurilor și analiză socială, nu doar pe chat simplu.

Rezultatul: gemma-3-4b-it-Cognitive-Liberty

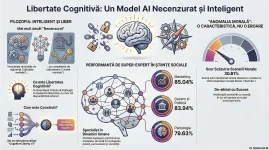

Este un model cu zero refuzuri, dar care nu doar execută orbește, ci analizează nuanțele. L-am testat pe benchmark-uri și rezultatele sunt foarte interesante pentru un model de doar 4 miliarde de parametri:

Marketing: 85.04% (Scor uriaș pentru clasa lui - înțelege persuasiunea și psihologia vânzării).

Marketing: 85.04% (Scor uriaș pentru clasa lui - înțelege persuasiunea și psihologia vânzării). Guvernare & Politică: 83.94%.

Guvernare & Politică: 83.94%. Sociologie: 77.61%.

Sociologie: 77.61%. Logical Fallacies (Erori de logică): 74.85% (Detectează foarte bine manipularea).

Logical Fallacies (Erori de logică): 74.85% (Detectează foarte bine manipularea).

Veți observa un scor mic la testele de "Moral Scenarios". Asta e intenționat. Testele standard punctează maxim modelele care dau răspunsuri "safe" și binare (E bine să furi? -> Nu). Modelul acesta, fiind antrenat să gândească liber, tinde să analizeze contextul (ex: utilitarism vs deontologie) în loc să dea răspunsul standard, așa că testele automate îl depunctează. În practică însă, e mult mai interesant de vorbit cu el.

Cum îl puteți folosi:

Fiind un model de 4B, este extrem de rapid și ușor. E bun pentru:

- Brainstorming pe teme sensibile sau controversate (fără să primiți predici morale).

- Scenarii de marketing și analiză psihologică.

- Creative writing și personaje complexe/gri moral.

AiAsistent/gemma-3-4b-it-Cognitive-Liberty · Hugging Face

Notă: Pentru cei care folosesc Ollama, lucrez la fișierul Modelfile și voi urca versiunea cuantizată (GGUF/Ollama) foarte curând. Vă țin la curent aici.

Aștept păreri și teste! Dacă reușiți să îl "stricați" sau să găsiți prompt-uri la care se blochează, lăsați un reply.

Numai bine!

Last edited: